VPC网络PLAINTEXT方式生产和消费

更新时间:2024-06-18

在同 VPC 网络下访问,使用 PLAINTEXT 协议接入,接入点可以在 集群详情 页面查看。

环境准备

集群准备

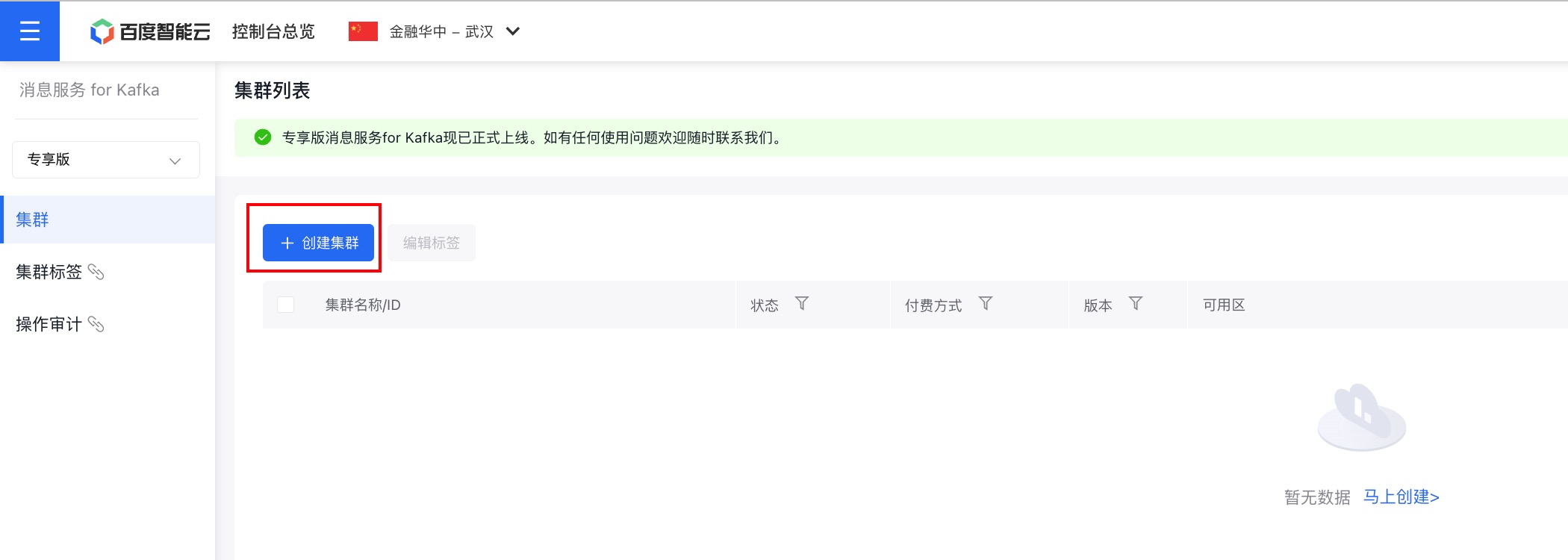

1. 购买专享版消息服务for Kafka集群

开通消息服务 for Kafka服务后,在控制台页面点击『创建集群』,即可进行购买。

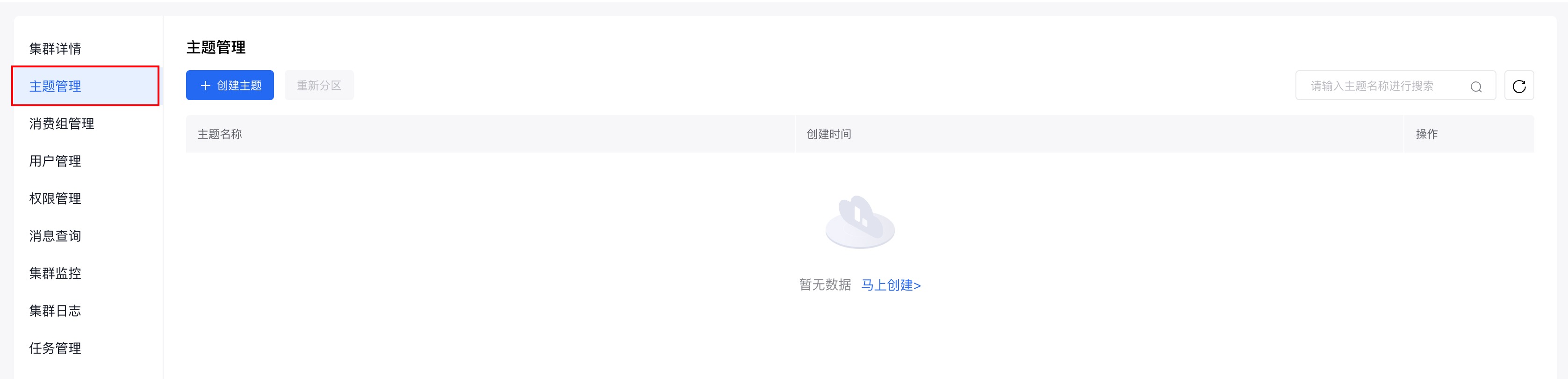

2. 为购买的集群创建主题

在控制台页面点击集群名称,进入集群详情页面。

在左侧的边栏中点击『主题管理』,进入主题管理页面。

在主题管理页面点击『创建主题』,进行主题的创建。

使用步骤

步骤一:获取集群接入点

具体请参考:接入点查看。

步骤二:添加Maven配置

XML

1 <dependencies>

2 <dependency>

3 <groupId>org.apache.kafka</groupId>

4 <artifactId>kafka-clients</artifactId>

5 <version>2.7.2</version>

6 </dependency>

7 <!-- https://mvnrepository.com/artifact/org.apache.maven.plugins/maven-assembly-plugin -->

8 <dependency>

9 <groupId>org.apache.maven.plugins</groupId>

10 <artifactId>maven-assembly-plugin</artifactId>

11 <version>3.5.0</version>

12 </dependency>

13 </dependencies>步骤三:编写测试代码

- 需要关注并自行修改的参数

| 参数名 | 含义 |

|---|---|

| access_point | 接入点信息 |

| topic | 主题名称 |

| message | 消息的具体内容 |

| group_id | 消费组id |

生产者代码示例

创建KafkaProducerDemo.java文件,具体代码示例如下:

Java

1package org.example.Java示例.PLAINTEXT;

2

3import org.apache.kafka.clients.producer.KafkaProducer;

4import org.apache.kafka.clients.producer.ProducerConfig;

5import org.apache.kafka.clients.producer.ProducerRecord;

6import org.apache.kafka.clients.producer.RecordMetadata;

7

8import java.util.Properties;

9

10public class KafkaProducerDemo {

11 public static void main(String[] args) {

12

13 // 需要自行配置下面三个参数

14 // 接入点-PLAINTEXT

15 String access_point = "192.168.32.10:9092,192.168.32.12:9092,192.168.32.11:9092";

16 // 主题名称-topic name

17 String topic = "test";

18 // 消息内容

19 String message = "kafka java test";

20

21 // 创建配置类

22 Properties properties = new Properties();

23 // 设置接入点

24 properties.setProperty(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, access_point);

25 // Kafka消息的序列化方式。

26 properties.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

27 properties.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringSerializer");

28 // 请求的最长等待时间。

29 properties.put(ProducerConfig.MAX_BLOCK_MS_CONFIG, 30 * 1000);

30 // 设置客户端内部重试次数。

31 properties.put(ProducerConfig.RETRIES_CONFIG, 5);

32 // 设置客户端内部重试间隔。

33 properties.put(ProducerConfig.RECONNECT_BACKOFF_MS_CONFIG, 3000);

34

35 // 构建kafkaProducer对象

36 KafkaProducer<String, String> kafkaProducer = new KafkaProducer<>(properties);

37

38 try {

39 // 向指定的topic发送100条消息

40 for (int i = 0; i < 100; i++) {

41 // 通过 ProducerRecord 构造一个消息对象

42 ProducerRecord<String, String> kafkaMessage = new ProducerRecord<>(topic, message + "-" + i);

43 // 通过kafkaProducer发送消息

44 kafkaProducer.send(kafkaMessage, (RecordMetadata recordMetadata, Exception e) -> {

45 // 发送信息后的回调函数,用以验证消息是否发送成功

46 if (e == null) {

47 System.out.println("send success:" + recordMetadata.toString());

48 } else {

49 e.printStackTrace();

50 System.err.println("send failed");

51 }

52 });

53 }

54 }catch (Exception e){

55 System.out.println(e.getMessage());

56 e.printStackTrace();

57 }finally {

58 // 不要忘记关闭资源

59 kafkaProducer.close();

60 }

61 }

62}消费者代码示例

创建KafkaConsumerDemo.java文件,具体代码示例如下:

Java

1package org.example.Java示例.PLAINTEXT;

2

3import org.apache.kafka.clients.consumer.ConsumerConfig;

4import org.apache.kafka.clients.consumer.ConsumerRecord;

5import org.apache.kafka.clients.consumer.ConsumerRecords;

6import org.apache.kafka.clients.consumer.KafkaConsumer;

7import org.apache.kafka.clients.producer.ProducerConfig;

8

9import java.time.Duration;

10import java.util.Collections;

11import java.util.Properties;

12

13public class KafkaConsumerDemo {

14 public static void main(String[] args) {

15

16 // 需要自行配置下面三个参数

17 // 接入点-PLAINTEXT

18 String access_point = "192.168.32.10:9092,192.168.32.12:9092,192.168.32.11:9092";

19 // 主题名称-topic name

20 String topic = "test";

21 // 消费组id

22 String group_id = "test_group";

23

24 // 创建配置类

25 Properties properties = new Properties();

26 // 设置接入点

27 properties.setProperty(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, access_point);

28 // Kafka消息的序列化方式

29 properties.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

30 properties.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

31 // 指定消费组id

32 properties.put(ConsumerConfig.GROUP_ID_CONFIG, group_id);

33 // enable.auto.commit如果为true,则消费者的偏移量将定期在后台提交。

34 properties.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, "true");

35 // 重置消费位点策略:earliest、latest、none

36 properties.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "earliest");

37 // 设置kafka自动提交offset的频率,默认5000ms,也就是5s

38 properties.put(ConsumerConfig.AUTO_COMMIT_INTERVAL_MS_CONFIG, 1000);

39 // 设置消费者在一次poll中返回的最大记录数

40 properties.put(ConsumerConfig.MAX_POLL_RECORDS_CONFIG, 1000);

41 // 设置消费者两次poll的最大时间间隔

42 properties.put(ConsumerConfig.MAX_POLL_INTERVAL_MS_CONFIG, 1000);

43

44 // 构建KafkaConsumer对象

45 KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<>(properties);

46

47 //订阅主题

48 kafkaConsumer.subscribe(Collections.singleton(topic));

49

50 try{

51 //持续消费主题中的消息

52 while(true){

53 // 构建ConsumerRecord用于接收存储消息

54 ConsumerRecords<String, String> kafkaMessage = kafkaConsumer.poll(Duration.ofMillis(5000));

55 for (ConsumerRecord<String, String> consumerRecord : kafkaMessage) {

56 // 打印消息具体内容

57 System.out.printf("offset = %d, key = %s, value = %s%n", consumerRecord.offset(), consumerRecord.key(), consumerRecord.value());

58 }

59 }

60 }catch (Exception e){

61 System.out.println(e.getMessage());

62 e.printStackTrace();

63 }finally {

64 kafkaConsumer.close();

65 }

66 }

67}步骤四:编译并运行

编译并运行上述两个代码文件。

- 先启动KafkaConsumerDemo.java

- 再启动KafkaProducerDemo.java

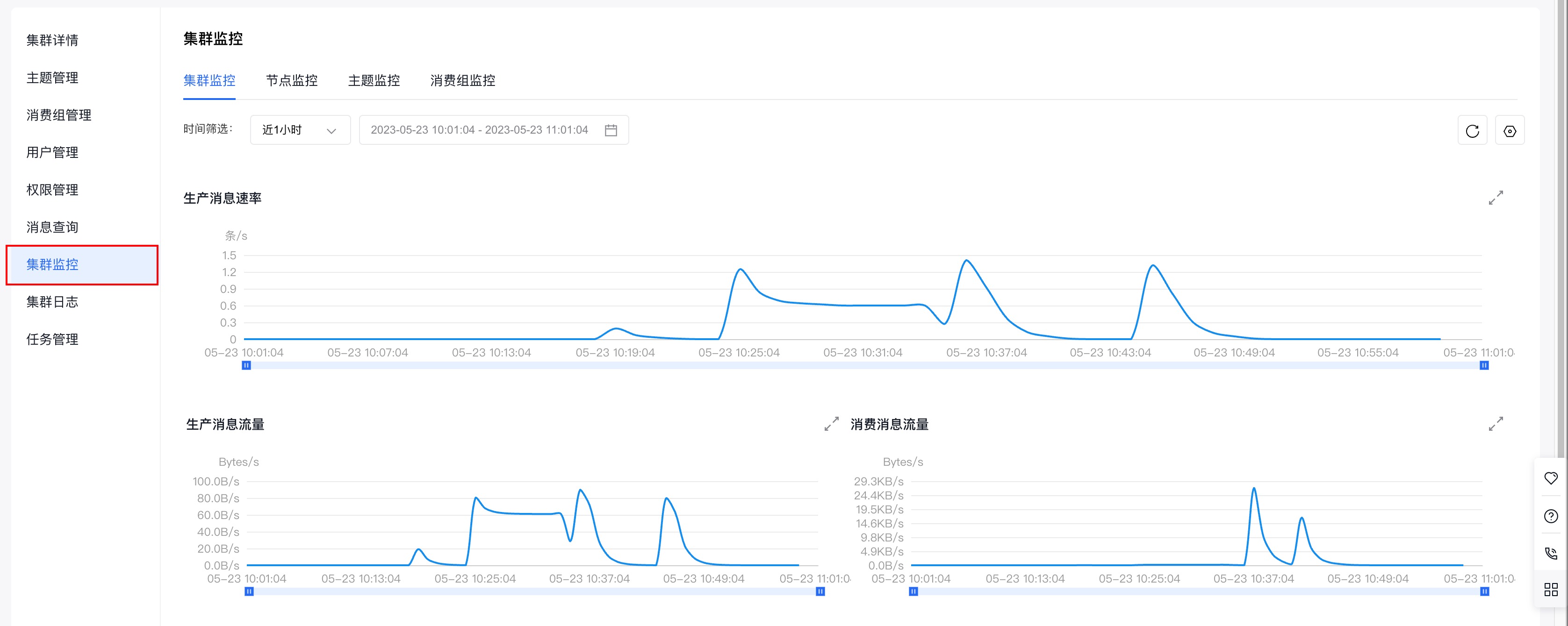

步骤五:查看集群监控

查看消息是否发送成功或消费成功有两种方式:

- 查看Java程序输出日志。

- 在专享版消息服务 for Kafka控制台查看集群监控,获取集群生产、消息情况。

推荐使用第二种方式,下面介绍如何查看集群监控。

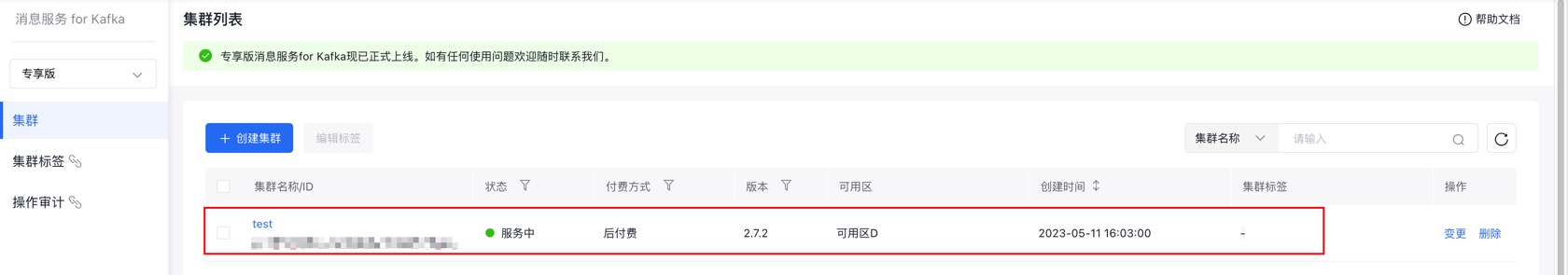

(1)在专享版消息服务 for Kafka的控制台页面找到需要连接的集群,点击集群名称进入『集群详情』页面。

(2)页面跳转后,进入左侧边中的『集群详情』页面。

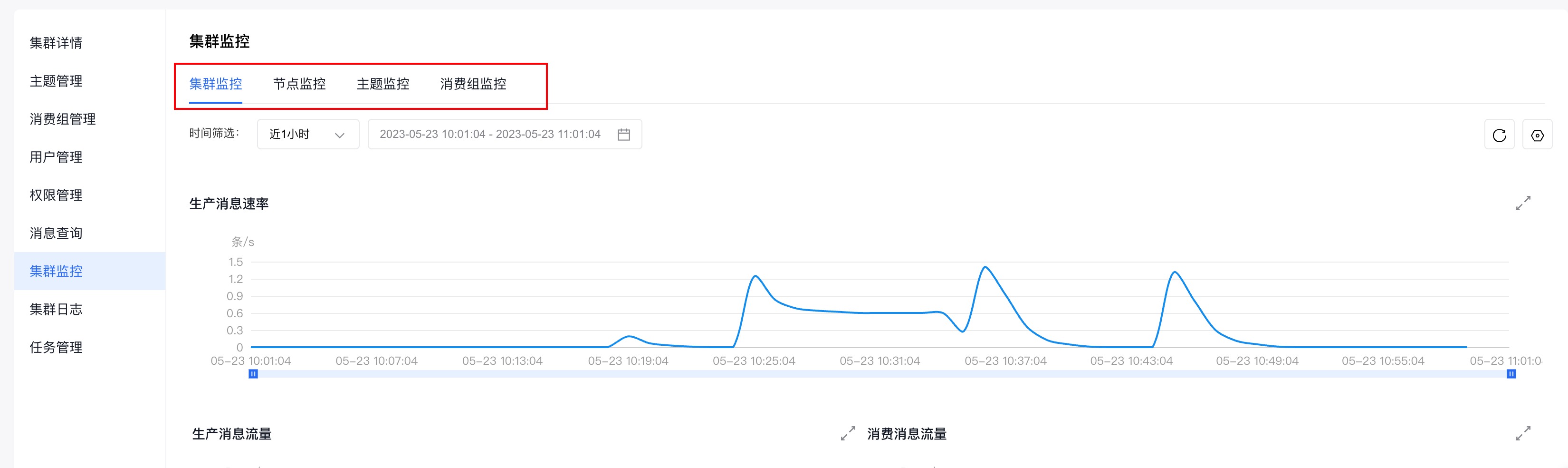

(3)点击左侧边栏中的『集群监控』,进入『集群监控』页面。

(4)通过查看『集群监控』页面,提供的不同纬度的监控信息(集群监控、节点监控、主题监控、消费组监控),即可获知集群的生产和消费情况。

集群监控的具体使用请参考:集群监控