公网SASL_SSL方式生产和消费消息

更新时间:2024-06-18

在 Kafka 集群所在 VPC 网络外访问,使用 SASL_SSL 协议接入,接入点可以在 集群详情 页面查看。

环境准备

- 安装Go。

- 下载Go kafka 客户端。

Go

1go get github.com/confluentinc/confluent-kafka-go集群准备

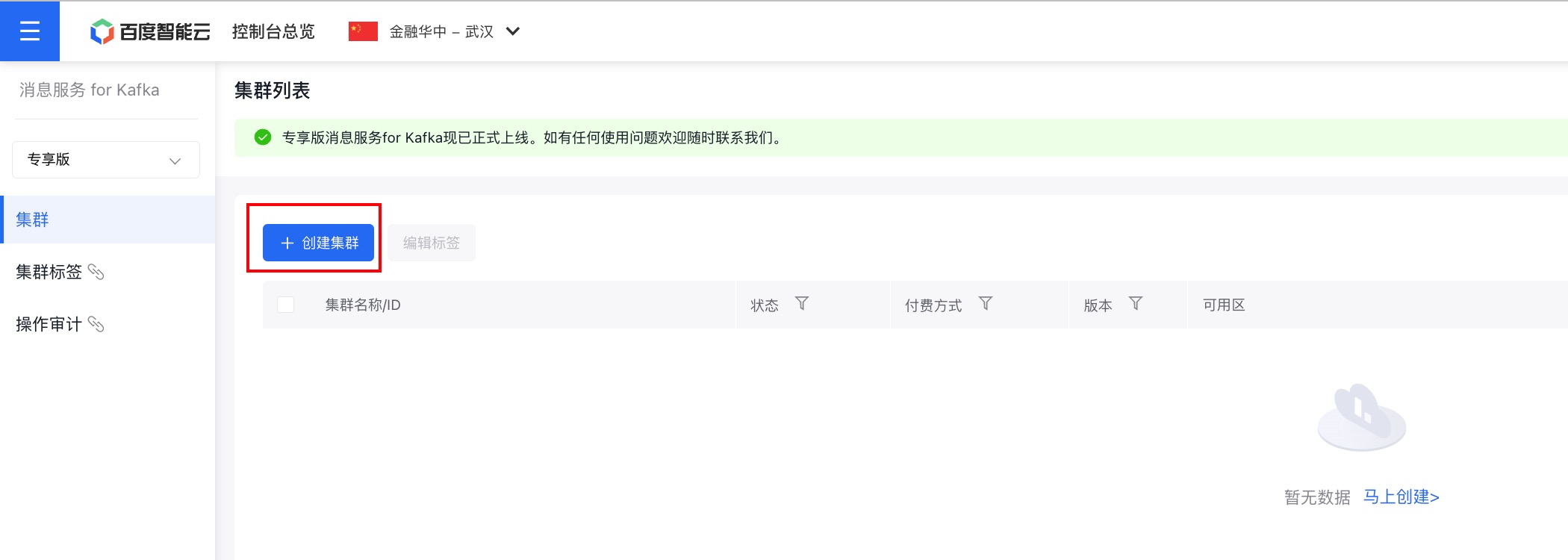

1. 购买专享版消息服务for Kafka集群

开通消息服务 for Kafka服务后,在控制台页面点击『创建集群』,即可进行购买。

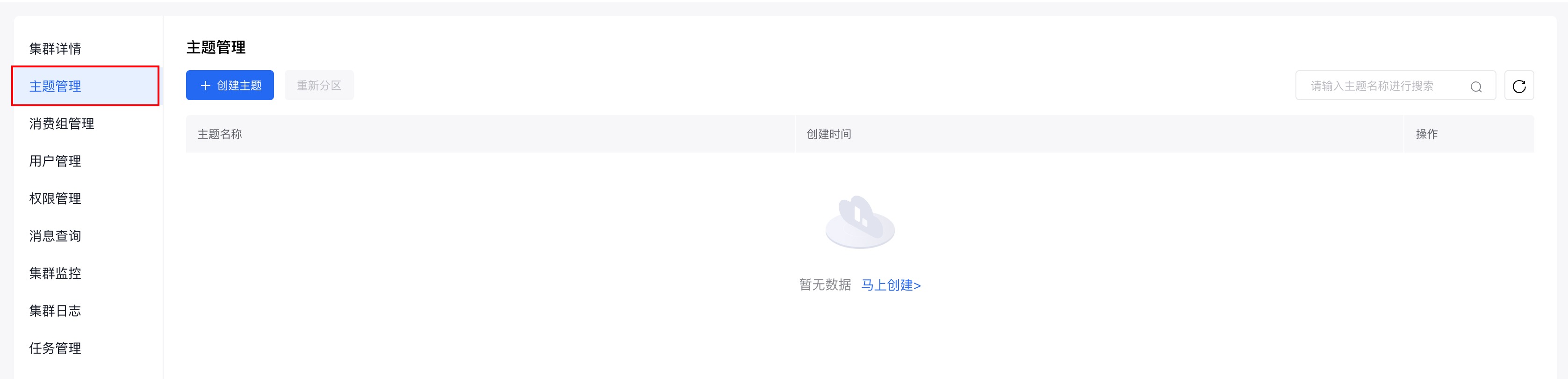

2. 为购买的集群创建主题

在控制台页面点击集群名称,进入集群详情页面。

在左侧的边栏中点击『主题管理』,进入主题管理页面。

在主题管理页面点击『创建主题』,进行主题的创建。

使用步骤:

步骤一:获取集群接入点

具体请参考:接入点查看。

步骤二:下载证书文件

下载证书文件:如何下载证书?

步骤三:编写测试代码

- 需要关注并自行修改的参数

- 认证机制支持PLAIN、SCRAM-SHA-512两种机制,根据集群所使用的认证方式进行选择

| 参数名 | 含义 |

|---|---|

| bootstrap_servers | 接入点信息 |

| topic_name | 主题名称 |

| ssl.ca.location | ca.pem文件所在路径 |

| sasl.username | 用户管理中创建用户的用户名 |

| sasl.password | 用户管理中创建用户的密码 |

| group_id | 消费组id |

生产者代码示例

创建KafkaProducerDemo.go文件,具体代码示例如下:

Shell

1package main

2

3import (

4"fmt"

5"github.com/confluentinc/confluent-kafka-go/kafka"

6)

7

8func main() {

9

10 var kafkaconf = &kafka.ConfigMap{

11 // 接入点

12 "bootstrap.servers": "接入点",

13 // 接入协议

14 "security.protocol": "sasl_ssl",

15 // 证书文件路径

16 "ssl.ca.location": "ca.pem",

17 // SASL 机制

18 "sasl.mechanism": "SCRAM-SHA-512",

19 // SASL 用户名

20 "sasl.username": "alice",

21 // SASL 用户密码

22 "sasl.password": "alice1234!",

23 }

24

25 p, err := kafka.NewProducer(kafkaconf)

26 if err != nil {

27 panic(err)

28 }

29

30 defer p.Close()

31

32 // Delivery report handler for produced messages

33 go func() {

34 for e := range p.Events() {

35 switch ev := e.(type) {

36 case *kafka.Message:

37 if ev.TopicPartition.Error != nil {

38 fmt.Printf("Delivery failed: %v\n", ev.TopicPartition)

39 } else {

40 fmt.Printf("Delivered message to %v\n", ev.TopicPartition)

41 }

42 }

43 }

44 }()

45

46 // 填写创建的主题名称

47 topic := "topic_name"

48 for _, word := range []string{"Golang", "for", "kafka", "client", "test"} {

49 p.Produce(&kafka.Message{

50 TopicPartition: kafka.TopicPartition{Topic: &topic, Partition: kafka.PartitionAny},

51 Value: []byte(word),

52 }, nil)

53 }

54

55 // Wait for message deliveries before shutting down

56 p.Flush(15 * 1000)

57}消费者代码示例

创建KafkaConsumerDemo.go文件,具体代码示例如下:

Shell

1package main

2

3import (

4"fmt"

5"github.com/confluentinc/confluent-kafka-go/kafka"

6)

7

8

9func main() {

10

11 var kafkaconf = &kafka.ConfigMap{

12 // 接入点

13 "bootstrap.servers": "接入点",

14 // 接入协议

15 "security.protocol": "sasl_ssl",

16 // 证书文件路径

17 "ssl.ca.location": "ca.pem",

18 // SASL 机制

19 "sasl.mechanism": "SCRAM-SHA-512",

20 // SASL 用户名

21 "sasl.username": "alice",

22 // SASL 用户密码

23 "sasl.password": "alice1234!",

24 // 消费组 id

25 "group.id": "test_group",

26 "auto.offset.reset": "earliest",

27 }

28

29 c, err := kafka.NewConsumer(kafkaconf)

30

31 if err != nil {

32 panic(err)

33 }

34

35 c.SubscribeTopics([]string{"topic_name"}, nil)

36

37 for {

38 msg, err := c.ReadMessage(-1)

39 if err == nil {

40 fmt.Printf("Message on %s: %s\n", msg.TopicPartition, string(msg.Value))

41 } else {

42 // The client will automatically try to recover from all errors.

43 fmt.Printf("Consumer error: %v (%v)\n", err, msg)

44 }

45 }

46

47 c.Close()

48}步骤四:编译并运行

运行上述两个代码文件。

Bash

1# 启动消费者

2go consumer.go

3# 启动生产者

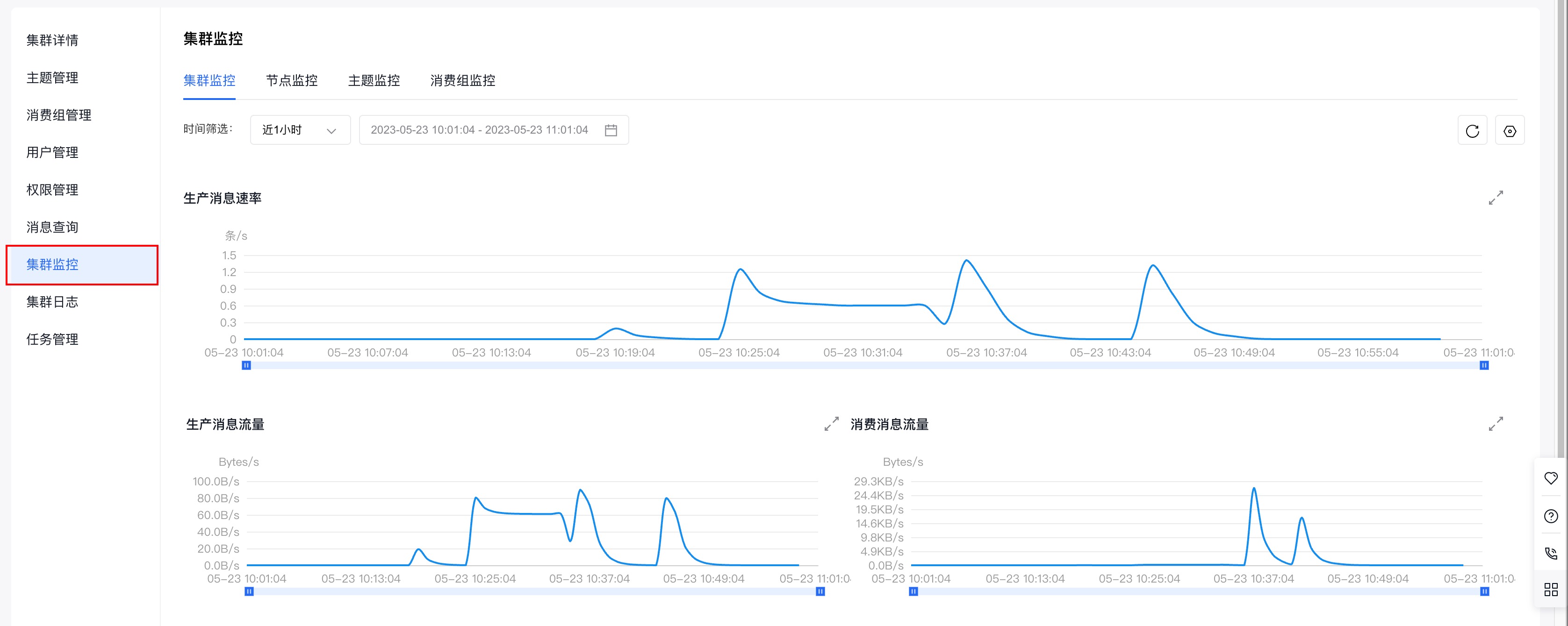

4go producer.go步骤五:查看集群监控

查看消息是否发送成功或消费成功有两种方式:

- 查看程序输出日志。

- 在专享版消息服务 for Kafka控制台查看集群监控,获取集群生产、消息情况。

推荐使用第二种方式,下面介绍如何查看集群监控。

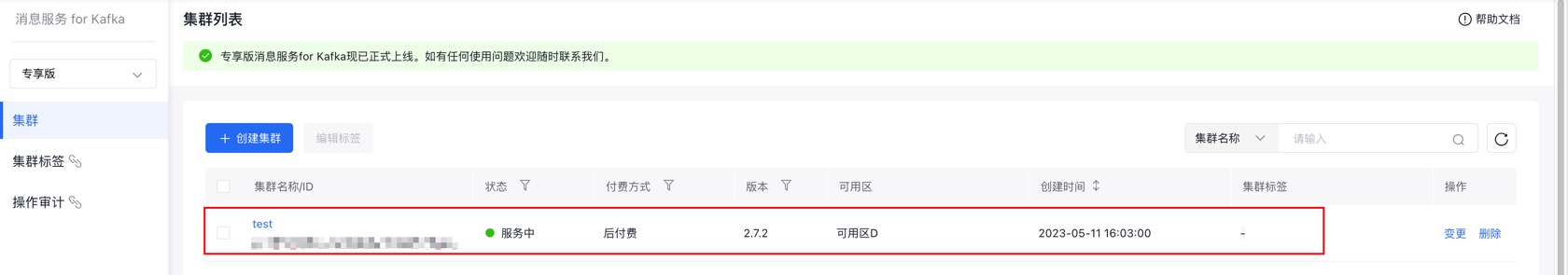

(1)在专享版消息服务 for Kafka的控制台页面找到需要连接的集群,点击集群名称进入『集群详情』页面。

(2)页面跳转后,进入左侧边中的『集群详情』页面。

(3)点击左侧边栏中的『集群监控』,进入『集群监控』页面。

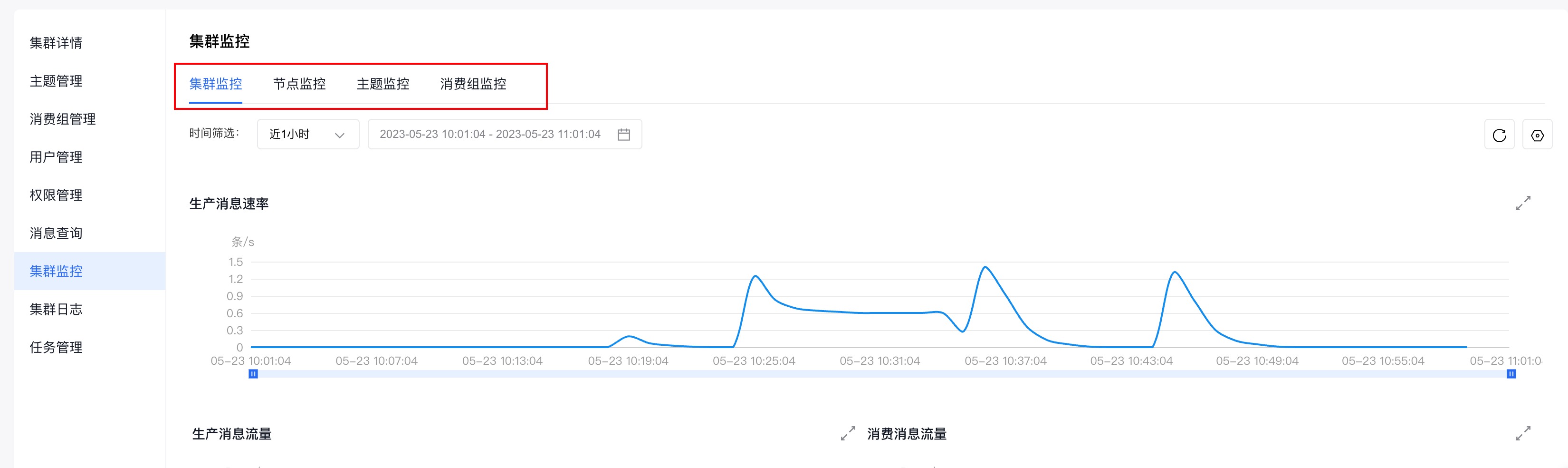

(4)通过查看『集群监控』页面,提供的不同纬度的监控信息(集群监控、节点监控、主题监控、消费组监控),即可获知集群的生产和消费情况。

集群监控的具体使用请参考:集群监控